-

每日简讯2023.12.17(周日)农历11月初五 1.王毅会见东盟国家驻华使节: 将继续奉行亲诚惠容周边外交理念;2.美国公布新一轮对台军售: 拟售台总价值约3亿美元的战术数据链路暨联战指管系统;3.美国与韩国决定在2024年中期前制定完成核战略;4.美国贸易代表谈对华关税: 不存在纯粹的自由贸易,美国必须为了与中国竞争而变得务实;5.欧盟预测: 乌克兰国库资金所剩无几,或在明年3月前破产;6.以色列军方首次承认误杀3名以人质,特拉维夫爆发游行,敦促政府主动采取措施确保哈马斯释放人质;7.俄罗斯: 明年试射7枚洲际弹道导弹,至少提前24小时通知美国;8.俄罗斯: 莫斯科积雪厚度达49厘米,刷新近150年纪录;9.世界旅游组织: 全球旅游业恢复到疫情前水平的近90%;10.国家金融监管总局: 养老保险公司不得受托管理保险资金;11.农业农村部: 落实防灾减灾措施,保障农民群众生命财产安全;12.工信部: 目前已有15家厂商的语言大模型产品通过备案,预计今年相关市场规模将达到132.3亿元,增长率将达到110%;13.国家疾控局: 至目前,国内已发现七例JN.1变异株,不排除流行可能;数据显示,JN.1变异株感染者均为轻型或无症状;14.报告显示,截至2021年底,我国劳动力平均年龄已逼近40岁,其中乡村男性劳动力已超40岁;15.山西运城市等多地血液库存告急: 寒冷天气街头献血骤减,官方呼吁市民助力;16.江西等多地机关单位发文倡议节约用电: 空调制热不超20℃,低楼层不坐电梯;17.北京: 2022年常住人口为2184.3万人,人口规模“六连降”;18.云南统计年鉴: 去年全省16个市州中有14个市州人口自然增长率告负;19.湖南: 近五年出生人口减半,教育部门拟组织幼儿园设并转撤;20.中央气象台发布今年首个低温预警: 未来一周大部地区气温将持续偏低;【特刊】国家冷知识~朝鲜1)朝鲜是世界上唯二两个买不到可口可乐的国家之一,另一个国家是古巴。2)朝鲜学生从小学到大学,只有上午有文化课,下午参加各类兴趣活动和劳动教育。3)医疗、子女教育和住房在朝鲜都是免费的。4)长白山脉最高峰在朝鲜境内,叫“将军峰”。5)和朝鲜接壤的国家不只有中国和韩国,还有俄罗斯,接壤只有16公里。6)在朝鲜只有军队或者政府官员才有资格使用汽车。7)朝鲜人民军大将以上还有次帅、元帅、大元帅。8)朝鲜与美国、日本都没有建交。【意林】........................................何谓知识分子?他首先要有知识,其次,他是分子。所谓分子,就是有独立性,否则分子不独立,知识也会变质。~北大教授王瑶

每日简讯2023.12.17(周日)农历11月初五 1.王毅会见东盟国家驻华使节: 将继续奉行亲诚惠容周边外交理念;2.美国公布新一轮对台军售: 拟售台总价值约3亿美元的战术数据链路暨联战指管系统;3.美国与韩国决定在2024年中期前制定完成核战略;4.美国贸易代表谈对华关税: 不存在纯粹的自由贸易,美国必须为了与中国竞争而变得务实;5.欧盟预测: 乌克兰国库资金所剩无几,或在明年3月前破产;6.以色列军方首次承认误杀3名以人质,特拉维夫爆发游行,敦促政府主动采取措施确保哈马斯释放人质;7.俄罗斯: 明年试射7枚洲际弹道导弹,至少提前24小时通知美国;8.俄罗斯: 莫斯科积雪厚度达49厘米,刷新近150年纪录;9.世界旅游组织: 全球旅游业恢复到疫情前水平的近90%;10.国家金融监管总局: 养老保险公司不得受托管理保险资金;11.农业农村部: 落实防灾减灾措施,保障农民群众生命财产安全;12.工信部: 目前已有15家厂商的语言大模型产品通过备案,预计今年相关市场规模将达到132.3亿元,增长率将达到110%;13.国家疾控局: 至目前,国内已发现七例JN.1变异株,不排除流行可能;数据显示,JN.1变异株感染者均为轻型或无症状;14.报告显示,截至2021年底,我国劳动力平均年龄已逼近40岁,其中乡村男性劳动力已超40岁;15.山西运城市等多地血液库存告急: 寒冷天气街头献血骤减,官方呼吁市民助力;16.江西等多地机关单位发文倡议节约用电: 空调制热不超20℃,低楼层不坐电梯;17.北京: 2022年常住人口为2184.3万人,人口规模“六连降”;18.云南统计年鉴: 去年全省16个市州中有14个市州人口自然增长率告负;19.湖南: 近五年出生人口减半,教育部门拟组织幼儿园设并转撤;20.中央气象台发布今年首个低温预警: 未来一周大部地区气温将持续偏低;【特刊】国家冷知识~朝鲜1)朝鲜是世界上唯二两个买不到可口可乐的国家之一,另一个国家是古巴。2)朝鲜学生从小学到大学,只有上午有文化课,下午参加各类兴趣活动和劳动教育。3)医疗、子女教育和住房在朝鲜都是免费的。4)长白山脉最高峰在朝鲜境内,叫“将军峰”。5)和朝鲜接壤的国家不只有中国和韩国,还有俄罗斯,接壤只有16公里。6)在朝鲜只有军队或者政府官员才有资格使用汽车。7)朝鲜人民军大将以上还有次帅、元帅、大元帅。8)朝鲜与美国、日本都没有建交。【意林】........................................何谓知识分子?他首先要有知识,其次,他是分子。所谓分子,就是有独立性,否则分子不独立,知识也会变质。~北大教授王瑶 -

-

-

聚焦品质,原始黄金铸就口碑企业 近年来,人们对健康的关注度不断提升,对营养的要求也越来越高。驼奶粉作为一种特殊的奶制品,逐渐受到人们的青睐。原始黄金作为新疆特色驼奶乳品企业,始终坚持以质量为核心,以健康为先的经营理念,深受消费者的信赖和喜爱。初心源自自然,匠心彰显优质原始黄金始终致力于“让每一滴驼奶都体现黄金品质”,直接在新疆北纬45°黄金奶源带,建立自己的牧场和饲养体系。这里气候适宜、水源充足、草木肥沃,为骆驼提供了良好的生长环境,使其拥有丰富优质的骆驼资源,为生产高品质驼奶粉提供了有力的保障。骆驼通过食用各种稀有沙漠植物和草药,这些富含药用价值的食料赋予了骆驼们哺育下一代的乳汁中含有令人称羡的丰富的营养成分,使骆驼奶不仅具有丰富的蛋白质和矿物质,还富含各种维生素和氨基酸,对人体有极好的健康作用。为保证驼奶粉的新鲜度和品质,原始黄金特别选在奶源腹地周边建厂,原奶2小时可直达工厂,全程2° C冷链密闭储运,保护好原奶新鲜营养和最佳口感。通过建设自动化生产线,采用数字化、智能化设备,能够高效地完成驼奶的净化、分离、杀菌等工序。原始黄金驼奶粉凭借其天然、高钙、易消化吸收及口感香浓等特点,满足了各年龄段人群对健康的需求,特别是对于存在健康问题,或是希望通过饮食调理来改善身体状况的人群。“4鲜”核心技术 还原驼奶天然本味企业自身也一直在不断追求创新和进步。在生产过程中,采用了先进的加工工艺国家专利“4鲜”驼奶核心技术,保留了驼奶中的营养成分和天然活性物质,确保产品品质和营养价值,以满足不同消费者的需求。而原始黄金更是以此核心技术荣获“第106届巴拿马万国博览会金奖”,该奖项被誉为工业届的“奥斯卡”。在研发理念上,原始黄金拥有专属研发团队,聘请亚洲乳制品营养顾问,综合升级产品优势,不断提升品牌竞争力,向消费者展示“新疆优质骆驼奶源”产业力量的同时树立健康驼奶的品牌信赖感。原始黄金凭借其优质奶源、先进工艺、严谨的生产流程、高品质产品以及完善的售后体系等优势,逐渐成为了驼奶行业的佼佼者。未来,原始黄金将继续秉承以质量为核心,以健康为先的经营理念,不断创新研发驼奶产品,以满足市场的不断变化和消费者日益增长的需求,为消费者带来更多高品质驼奶。

聚焦品质,原始黄金铸就口碑企业 近年来,人们对健康的关注度不断提升,对营养的要求也越来越高。驼奶粉作为一种特殊的奶制品,逐渐受到人们的青睐。原始黄金作为新疆特色驼奶乳品企业,始终坚持以质量为核心,以健康为先的经营理念,深受消费者的信赖和喜爱。初心源自自然,匠心彰显优质原始黄金始终致力于“让每一滴驼奶都体现黄金品质”,直接在新疆北纬45°黄金奶源带,建立自己的牧场和饲养体系。这里气候适宜、水源充足、草木肥沃,为骆驼提供了良好的生长环境,使其拥有丰富优质的骆驼资源,为生产高品质驼奶粉提供了有力的保障。骆驼通过食用各种稀有沙漠植物和草药,这些富含药用价值的食料赋予了骆驼们哺育下一代的乳汁中含有令人称羡的丰富的营养成分,使骆驼奶不仅具有丰富的蛋白质和矿物质,还富含各种维生素和氨基酸,对人体有极好的健康作用。为保证驼奶粉的新鲜度和品质,原始黄金特别选在奶源腹地周边建厂,原奶2小时可直达工厂,全程2° C冷链密闭储运,保护好原奶新鲜营养和最佳口感。通过建设自动化生产线,采用数字化、智能化设备,能够高效地完成驼奶的净化、分离、杀菌等工序。原始黄金驼奶粉凭借其天然、高钙、易消化吸收及口感香浓等特点,满足了各年龄段人群对健康的需求,特别是对于存在健康问题,或是希望通过饮食调理来改善身体状况的人群。“4鲜”核心技术 还原驼奶天然本味企业自身也一直在不断追求创新和进步。在生产过程中,采用了先进的加工工艺国家专利“4鲜”驼奶核心技术,保留了驼奶中的营养成分和天然活性物质,确保产品品质和营养价值,以满足不同消费者的需求。而原始黄金更是以此核心技术荣获“第106届巴拿马万国博览会金奖”,该奖项被誉为工业届的“奥斯卡”。在研发理念上,原始黄金拥有专属研发团队,聘请亚洲乳制品营养顾问,综合升级产品优势,不断提升品牌竞争力,向消费者展示“新疆优质骆驼奶源”产业力量的同时树立健康驼奶的品牌信赖感。原始黄金凭借其优质奶源、先进工艺、严谨的生产流程、高品质产品以及完善的售后体系等优势,逐渐成为了驼奶行业的佼佼者。未来,原始黄金将继续秉承以质量为核心,以健康为先的经营理念,不断创新研发驼奶产品,以满足市场的不断变化和消费者日益增长的需求,为消费者带来更多高品质驼奶。 - 原始黄金中老年奶粉 创新配方助力健康生活 随着中老年人口数量的持续增长,让“银发经济”产业有了更广阔的增量空间,能够满足一次性补充多种营养元素的中老年奶粉已经逐渐成为他们的“新宠”。原始黄金瞄准中老年奶粉这个新的潜力市场,以新品原始黄金中老年新疆驼奶粉入局银发营养新赛道。这款产品是原始黄金品牌理念的全新体现,以优质新疆双峰骆驼乳为基础,科学配方结合先进工艺,为中老年人群量身定制了一款营养丰富、有助于调节机体平衡,增强防护力,促进中老年人身体健康的高品质奶粉。银发经济助推 原始黄金新品出圈中老年人群是一个特殊的群体,他们对营养的需求和代谢特点也与年轻时有所不同。因此,为他们提供一种能够满足特殊需求,同时又易于消化吸收的奶粉至关重要。原始黄金中老年奶粉就是针对这一人群特点精心研发而成的,与其他奶粉相比,原始黄金中老年奶粉的优势在于它的创新配方。同时,原始黄金在制作工艺上精益求精,采用国家专利“4鲜”驼奶核心技术,最大程度保留了驼奶中的原有活性物质,包括类胰岛素生长因子、乳铁传递蛋白、溶解酵素,以及蛋白质、矿物质、维生素和多种氨基酸。其全面均衡的营养成分,为追求健康饮食的中老年朋友们提供全新的营养体验。独特创新配方 助力中老年健康原始黄金中老年奶粉通过对L-阿拉伯糖、N-乙酰神经氨酸、磷脂酰丝氨酸、植物甾醇酯等这几种具有生物学特性的新资源食品原料进行科学调配、合理添加,使该产品更符合中老年人群新陈代谢特点。这款新品秉持品牌一贯的宗旨,遵循自然理念,用料真,营养真,始终坚持不添加香精、色素等人工添加物质,确保产品的健康。以天然的方式呈现驼奶原本的美味与营养,让中老年人在享受美味的同时,感受到健康与快乐。原始黄金中老年驼奶粉的上市,无疑为中老年人提供了一个新的、健康的、美味的营养来源,其独特的口感和丰富的营养价值深受中老年人群的喜爱。在市场上众多骆驼乳制品中,原始黄金以它独特的优势和深厚的品牌实力,再次证明了它在健康食品领域的领先地位。原始黄金品牌未来还将继续致力于研发更多针对不同年龄段人群的健康食品,为消费者提供全方位的健康解决方案。

- 原始黄金驼乳益生菌,引领肠道健康新潮流! 维持肠道内微生态平衡对人体健康至关重要。原始黄金为了推动肠道微生态营养与健康产业的未来发展,经过不断探索创新,推出了一款全新的产品 — 原始黄金驼乳型益生菌。原始黄金驼乳型益生菌有别于其他益生菌产品的地方在于:特别添加了珍稀新疆双峰驼乳。驼乳被誉为“沙漠白金”,是珍贵的动物乳之一。与传统的牛乳相比,驼乳的营养成分更加丰富且更易于消化吸收。而原始黄金运用现代科技手段,将驼乳与益生菌进行完美结合,使其在保持原有营养成分的同时,更增强了其调节肠道菌群、提高防护力等功效。菌驼组团出道,配方可循证在研发的道路上,原始黄金提倡科学循证,为了给肠道更科学的养护,特地选用来自新疆北纬45°黄金奶源地的优质驼乳,经过科学提取和精制加工,加入了益生菌成分,通过驼乳益生元和18种活性菌株的独特组合,创造出了1+1大于2的协同效应。特别添加的新疆驼乳作为“益生元”,能使益生菌效能加倍,稳固肠道健康,其特有的小分子结构及低过敏、提高防护力的优点,温和好吸收,更能保护“玻璃胃”。与此同时,原始黄金注重各菌株之间的配比,科学调配菌菌协同,形成了营养丰富、易于吸收的益生菌饮品,能更好的在人体中更好地发挥作用,呵护全家人肠道健康。菌株挖掘,选菌可循证在产品研发方面,原始黄金致力于从源头抓起,精挑细选只为甄选出优质菌株。好菌株不仅自身品质优秀,还可以互相协同、提升产品的整体效果。原始黄金益生菌冻干粉添加了13种自然提取天然活性菌株,5大专利菌株。每一株都拥有独立的编码和临床循证科学依据,更加可靠。4大技术,活性更高更有效想要长期调节肠道内菌群,必须要有更强的定植性,而原始黄金益生菌能够精准定植驻扎在肠道中,主要归功于其拥有的4大核心锁活技术,最大程度确保益生菌可以高效存活。特别采取冻干技术抵抗胃酸和胆汁,减少益生菌“路途”中的损伤;通过三层包埋包装设计,实现低透光率、低透水率、低透氧率,帮助提升益生菌活性,产品中的活菌数更是高达12000亿CFU。除此之外,原始黄金益生菌还拥有8项发明专利,充分展现了品牌在研发过程中的专业与用心。口感体感 双重提升原始黄金益生菌坚持高标准生产,配方纯净温和,不含有香精、色素、防腐剂、蔗糖和乳糖,也不含八大过敏原,满足了消费者对产品更“纯净”、更安全的需求。在未来的日子里,原始黄金将继续关注消费者需求和市场变化,不断推陈出新,以卓越的品质和丰富的营养满足人们多元化的健康需求。

- 原始黄金以高品质好驼奶,不断打动消费者 在当今的消费市场中,人们对于驼奶粉的选择越来越注重品质和健康。而在众多品牌中,原始黄金以其独特的品质和营养价值,成为了消费者们追求健康的首选。原始黄金深耕品质 探索鲜萃活性营养原始黄金驼奶粉作为该品牌的明星产品之一,凭借其独特的成分和营养价值受到了消费者的热烈追捧。与传统奶制品相比,驼奶粉具有更加丰富的营养价值,同时对于乳糖不耐受的人群也更加友好。原始黄金驼奶粉不仅口感顺滑、细腻,更具有低过敏、提高防护力的优点,为消费者提供了更加健康的饮品选择。原始黄金品牌坚持自然健康的产品理念和对健康的追求。致力于从源头抓起,通过甄选优质的原材料,结合先进的现代化生产工艺,为消费者提供更加安全、健康的食品。凭借着多年的品牌信誉和卓越的产品质量,原始黄金已经成为了中国驼奶行业的领军企业之一。原始黄金不负众望,以好口碑不断斩获荣誉大奖原始黄金在驼奶行业深耕多年,品牌创立之初即设立研发中心,并坚持投入巨资自主研发,用精英研发团队创新产品品质,将追求极致的精神渗透到设计的每一处细节中。此外,还通过社交媒体、电视广告和线下活动等多种方式向消费者传递品牌理念和健康饮食文化,让更多人了解到原始黄金对于品质和健康的追求。为了让更多消费者了解并选择原始黄金品牌,品牌更是强势入驻各大电商平台,只为让消费者都可以轻松地购买到原始黄金驼奶粉等明星产品。而原始黄金也不负众望,凭借卓越的产品品质、突出的创新研发能力以及良好的市场口碑,受到众多消费者的肯定,在激烈的竞争中脱颖而出,连续2年蝉联全国销量第一。同时以万里挑一的高品质,被推选为“国货之光”,荣获新华网《了不起的国货》栏目重点推荐。‘4鲜’核心驼奶技术,只为缔造高品质驼奶原始黄金驼奶粉更是品牌的代表性产品之一,企业自身也一直在不断追求创新和进步。在生产过程中,采用了先进的加工工艺‘4鲜”核心技术’,保留了驼奶中的营养成分和天然活性物质,确保产品品质和营养价值。此外,还针对不同消费人群推出了不同规格和口感的驼奶粉产品,以满足不同消费者的需求。而原始黄金更是以此核心技术荣获“第106届巴拿马万国博览会金奖”,该奖项被誉为工业届的“奥斯卡”。多元化产品体系 满足人群多样化健康需求除了驼奶粉之外,原始黄金还积极拓展产品线。目前,已经推出了多种不同类型和功效的食品,如胶原蛋白女性奶粉、儿童成长奶粉、驼奶益生菌等一系列产品。这些产品同样采用了优质的原料和精湛的工艺,为消费者提供了更多健康选择。未来,原始黄金将继续秉持“为健康而选择”的品牌理念,不断创新和发展。将继续深化对大自然的探索和研究,为消费者带来更多优质的食品和饮品。同时,也将继续拓展国内外市场,与各界合作伙伴共同推动健康产业的发展壮大。相信在不久的将来,原始黄金必将成为全球消费者信赖的健康食品品牌!

- K8S工作节点运行kubectl命令报错的原因及解决办法 K8S工作节点运行kubectl命令报错:The connection to the server localhost:8080 was refused - did you specify the right host or port?。原因分析:这是因为kubectl命令需要使用kubernetes-admin来运行,而工作节点上如果没有配置好相关的权限是无法执行的。可以用kubectl config view 命令查看,如下图可以看出节点2上是没有权限执行的。解决办法:1、将主节点中的【/etc/kubernetes/admin.conf】文件拷贝到从节点1相同目录下。如图2、回到工作节点1上配置环境变量:echo "export KUBECONFIG=/etc/kubernetes/admin.conf" >> ~/.bash_profile如图:3、加载配置信息,source ~/.bash_profile4、查验是否正常执行kubectl命令.

-

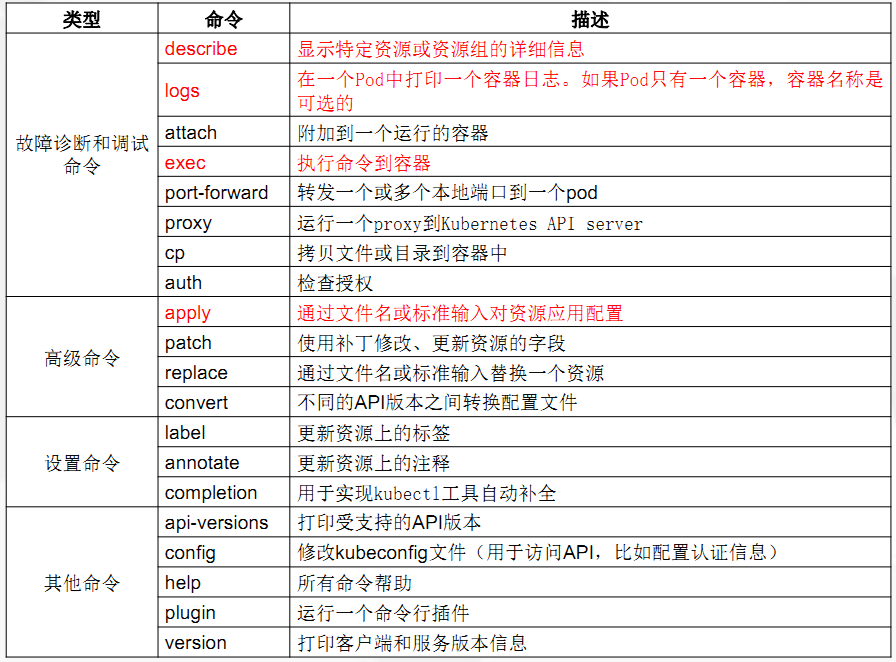

Kubernetes 常用命令汇总 # 通过文件名或标准输入创建资源。kubectl create # 读取指定文件内容,进行创建。(配置文件可指定json,yaml文件)。 kubectl create -f 配置文件 # 创建指定文件内容,创建并指定服务版本。(配置文件可指定json,yaml文件)。 kubectl create -f 配置文件 --edit --output-version=版本号 -o json # 将一个资源公开为一个新的Kubernetes服务,暴露服务。kubectl expose # 创建Kubernetes 资源类型,并添加暴露端口。 kubectl expose 资源类型 资源名称 --port=暴露端口 --target-port=容器端口 # 创建Kubernetes service 服务,并添加暴露端口。 kubectl expose service 资源名称 --port=暴露端口 --target-port=容器端口 --name=创建服务名称 # 创建Kubernetes ,并添加UDP暴露端口,使用默认容器端口。 kubectl expose 资源类型 资源名称 --port=暴露端口 --protocol=udp --name=创建服务名称 # 创建Kubernetes服务,根据yaml文件,并添加暴露端口。(配置文件可指定json,yaml文件)。 kubectl expose -f 配置文件 --port=暴露端口 --target-port=容器端口# 创建并运行一个特定的镜像,可能是副本。创建一个deployment或job管理创建的容器。kubectl run # 创建一个镜像,运行。 kubectl run 容器名 --image=镜像名 # 创建一个镜像,运行。并启用暴露端口。 kubectl run 容器名 --image=镜像名 --port=暴露端口 # 创建一个镜像,运行。并引入变量。 kubectl run 容器名 --image=镜像名 --env=“变量” # 创建一个镜像,运行。并引入标签。 kubectl run 容器名 --image=镜像名 --labels="key=value,env=prod" # 创建一个镜像,运行。并设置副本数。默认1。 kubectl run 容器名 --image=镜像名 --replicas=副本数 # 创建一个镜像,运行。并添加-i-t访问容器终端。并设置重启策略(Never不重启)。 kubectl run -i -t 容器名 --image=镜像名 --restart=重启策略 # 创建一个镜像,运行。并指定容器内执行指定命令。 kubectl run 容器名 --image=镜像名 --command -- 指定命令删# 通过文件名、标准输入、资源名称或标签选择器来删除资源kubectl delete # 删除指定资源。 kubectl delete 资源类型 资源名 # 删除所有指定资源。 kubectl delete 资源类型 -all # 通过指定文件删除指定资源。(配置文件.json .yaml) kubectl delete -f 配置文件# 维护期间排除容器名kubectl drain # 排除指定容器名。 kubectl drain 容器名改# 配置应用资源。修改现有应用程序资源。kubectl set # 更新pod内的环境变量。 kubectl set env 资源类型 资源名称 添加变量=值 # 更新pod镜像。 kubectl set image 资源类型 资源名称 容器名=升级镜像版本 # 更新pod内的资源。 kubectl set resources 资源类型 资源名称 [请求——限制= & =请求][选项] # 通过配置文件更新pod内的资源。(配置文件.json .yaml) kubectl set resources -f 配置文件# 使用默认的编辑器编辑一个资源。kubectl edit # 动态更新服务配置参数。 kubectl edit 资源类型 资源名称# 管理资源的发布。kubectl rollout # 回滚到上一个版本。 kubectl rollout undo 资源类型 资源名称 # 指定版本回滚。 kubectl rollout undo 资源类型 资源名称 --to-revision=3 # 查看当前的资源状态。 kubectl rollout status 资源类型 资源名称 # 查看历史修订版本 kubectl rollout history 资源类型 资源名称 # 查看指定历史修订版本 kubectl rollout history 资源类型 资源名称 --revision=版本数# 执行指定复制控制的滚动更新。kubectl rolling-update # 滚动更新v1版本,通过json配置文件跟新到v2版本。 kubectl rolling-update 服务名称-v1 -f 服务名称-v2.json # 滚动更新v1版本,到v2,并指定更新镜像。 kubectl rolling-update 服务名称-v1 服务名称-v2 --image=image:v2# 扩容或缩容Pod数量,Deployment、ReplicaSet、RC或Jobkubectl scale # 扩容缩容副本数。 kubectl scale --replicas=副本数 资源类型 资源名称 # 扩容缩容副本数。对多个资源扩容。 kubectl scale --replicas=副本数 资源类型/资源名称1 资源类型/资源名称2 # 扩容缩容副本数。如果当前副本数为N个就扩容为Y个。 kubectl scale --current-replicas=副本数N --replicas=副本数Y 资源类型 资源名称# 创建一个自动选择扩容或缩容并设置Pod数量kubectl autoscale # 设置该资源类型的副本数自动扩容到相关值 kubectl autoscale 资源类型 资源名称 --min=最小值 --max=最大值 # 设置该资源类型的副本数自动扩容到相关值。并根据CPU阈值扩容缩容。 kubectl autoscale 资源类型 资源名称 --max=最大值 --最小值 --cpu-percent=80# 修改证书资源。kubectl certificate# 标记节点不可调度kubectl cordon # 标记指定节点不可调度 kubectl cordon 节点名# 标记节点可调度kubectl uncordon # 标记指定节点可调度 kubectl uncordon 节点名 # 更新一个或多个节点上的nodes。kubectl taint # 执行命令到容器。kubectl exec # 执行指定命令到容器中。 kubectl exec 容器名 命令 # 分配伪终端已宿主级向容器添加命令。 kubectl exec 容器名 -- bash -c “命令” # 进入指定节点容器内。 kubectl exec 容器名 -it bash# 转发一个或多个本地端口到一个pod。kubectl port-forward # 将宿主级端口转发到容器中。 kubectl port-forward 容器名 宿主级端口:容器端口# 为kubernetes API Server启动服务代理kubectl proxy# 拷贝文件或目录到容器中。kubectl cp # 附加到一个进程到一个已经运行的容器。kubectl attach # 进入到一个运行的容器终端。 kubectl attach 容器名 # 通过文件名或标准输入对资源应用配置kubectl apply# 更新部署配置文件信息(配置文件格式.json .yaml)kubectl apply -f 配置文件 # 使用补丁修改、更新资源的字段。kubectl patch# 通过文件名或标准输入替换一个资源。kubectl replace # 重新创建配置文件内的资源 。配置文件可是(.yaml、.json) kubectl replace -f 配置文件 --force # 不同的API版本之间转换配置文件。YAML和JSON格式都接受。kubectl convert# 更新资源上的标签kubectl label# 在一个或多个资源上更新注释。kubectl annotate# 修改kubeconfig文件(用于访问API,比如配置认证信息)kubectl config查# 显示一个或多个资源kubectl get # 查看组件运行状态 kubectl get componentstatus # 查看节点加入信息 kubectl get node # 查看所有资源 kubectl get all # 查看pods状态 kubectl get pods # 查看pods及运行节点位置,查看更多信息 kubectl get pods -o wide # 查看pods下其他命名空间(kube-system等) kubectl get pods -n 命名空间 # 查看endpoints节点 kubectl get endpoints # 查看sservice暴露宿主级访问地址描述信息 kubectl get service # 根据标签查找资源描述信息。--output=wide查看更多信息。 kubectl get 资源类型 --selector="key=value" --output=wide # 查看资源所有标签 kubectl get 资源类型 --show-labels # 根据标签查看资源 kubectl get 资源类型 -l app=example # 查看指定命名空间的资源 kubectl get 资源类型 --namespace=kube-system # 查看命名空间 kubectl get ns# 文档参考资料,可查看yaml文件字段指令含义。kubectl explain # 获得资源的特定字段的文档 kubectl explain pods.spec.containers # 获得资源及其字段的文档 kubectl explain pods# 显示集群信息kubectl cluster-info # 显示详细集群信息 kubectl cluster-info dump# 显示资源(CPU/Memory/Storage)使用。需要Heapster运行。kubectl top# 显示特定资源或资源组的详细信。kubectl describe # 查看资源详细信息 kubectl describe 资源类型 资源名称 # 指定标签。详细信息。 kubectl describe 资源类型 -l name=标签名 # 查看node资源使用详情信息 kubectl describe nodes NodeIP# 在od或指定的资源中容器打印日志。如果od只有一个容器,容器名称是可选的。kubectl logs # 查看指定节点服务日志。 kubectl logs 容器名 # 查看指定容器日志。 kubectl logs pod 节点名 -c 容器名 # 查看指定容器日志。实时查看。 kubectl logs pod 容器名 -f # 通过标签查看容器日志 kubectl logs -l key=value其他# 检查认证授权kubectl auth# 用于实现kubectl工具自动补全kubectl completion# 执行实现自动补全动作source <(kubectl completion bash)# 打印受支持的API版本kubectl api-versions# 所有命令帮助。kubectl help# 运行一个命令行插件。kubectl plugin# 打印客户端和服务版本信息kubectl versionkubernetes官网https://kubernetes.io/kubernetes官方文档其他命令https://v1-8.docs.kubernetes.io/docs/reference/generated/kubectl/kubectl-commands

Kubernetes 常用命令汇总 # 通过文件名或标准输入创建资源。kubectl create # 读取指定文件内容,进行创建。(配置文件可指定json,yaml文件)。 kubectl create -f 配置文件 # 创建指定文件内容,创建并指定服务版本。(配置文件可指定json,yaml文件)。 kubectl create -f 配置文件 --edit --output-version=版本号 -o json # 将一个资源公开为一个新的Kubernetes服务,暴露服务。kubectl expose # 创建Kubernetes 资源类型,并添加暴露端口。 kubectl expose 资源类型 资源名称 --port=暴露端口 --target-port=容器端口 # 创建Kubernetes service 服务,并添加暴露端口。 kubectl expose service 资源名称 --port=暴露端口 --target-port=容器端口 --name=创建服务名称 # 创建Kubernetes ,并添加UDP暴露端口,使用默认容器端口。 kubectl expose 资源类型 资源名称 --port=暴露端口 --protocol=udp --name=创建服务名称 # 创建Kubernetes服务,根据yaml文件,并添加暴露端口。(配置文件可指定json,yaml文件)。 kubectl expose -f 配置文件 --port=暴露端口 --target-port=容器端口# 创建并运行一个特定的镜像,可能是副本。创建一个deployment或job管理创建的容器。kubectl run # 创建一个镜像,运行。 kubectl run 容器名 --image=镜像名 # 创建一个镜像,运行。并启用暴露端口。 kubectl run 容器名 --image=镜像名 --port=暴露端口 # 创建一个镜像,运行。并引入变量。 kubectl run 容器名 --image=镜像名 --env=“变量” # 创建一个镜像,运行。并引入标签。 kubectl run 容器名 --image=镜像名 --labels="key=value,env=prod" # 创建一个镜像,运行。并设置副本数。默认1。 kubectl run 容器名 --image=镜像名 --replicas=副本数 # 创建一个镜像,运行。并添加-i-t访问容器终端。并设置重启策略(Never不重启)。 kubectl run -i -t 容器名 --image=镜像名 --restart=重启策略 # 创建一个镜像,运行。并指定容器内执行指定命令。 kubectl run 容器名 --image=镜像名 --command -- 指定命令删# 通过文件名、标准输入、资源名称或标签选择器来删除资源kubectl delete # 删除指定资源。 kubectl delete 资源类型 资源名 # 删除所有指定资源。 kubectl delete 资源类型 -all # 通过指定文件删除指定资源。(配置文件.json .yaml) kubectl delete -f 配置文件# 维护期间排除容器名kubectl drain # 排除指定容器名。 kubectl drain 容器名改# 配置应用资源。修改现有应用程序资源。kubectl set # 更新pod内的环境变量。 kubectl set env 资源类型 资源名称 添加变量=值 # 更新pod镜像。 kubectl set image 资源类型 资源名称 容器名=升级镜像版本 # 更新pod内的资源。 kubectl set resources 资源类型 资源名称 [请求——限制= & =请求][选项] # 通过配置文件更新pod内的资源。(配置文件.json .yaml) kubectl set resources -f 配置文件# 使用默认的编辑器编辑一个资源。kubectl edit # 动态更新服务配置参数。 kubectl edit 资源类型 资源名称# 管理资源的发布。kubectl rollout # 回滚到上一个版本。 kubectl rollout undo 资源类型 资源名称 # 指定版本回滚。 kubectl rollout undo 资源类型 资源名称 --to-revision=3 # 查看当前的资源状态。 kubectl rollout status 资源类型 资源名称 # 查看历史修订版本 kubectl rollout history 资源类型 资源名称 # 查看指定历史修订版本 kubectl rollout history 资源类型 资源名称 --revision=版本数# 执行指定复制控制的滚动更新。kubectl rolling-update # 滚动更新v1版本,通过json配置文件跟新到v2版本。 kubectl rolling-update 服务名称-v1 -f 服务名称-v2.json # 滚动更新v1版本,到v2,并指定更新镜像。 kubectl rolling-update 服务名称-v1 服务名称-v2 --image=image:v2# 扩容或缩容Pod数量,Deployment、ReplicaSet、RC或Jobkubectl scale # 扩容缩容副本数。 kubectl scale --replicas=副本数 资源类型 资源名称 # 扩容缩容副本数。对多个资源扩容。 kubectl scale --replicas=副本数 资源类型/资源名称1 资源类型/资源名称2 # 扩容缩容副本数。如果当前副本数为N个就扩容为Y个。 kubectl scale --current-replicas=副本数N --replicas=副本数Y 资源类型 资源名称# 创建一个自动选择扩容或缩容并设置Pod数量kubectl autoscale # 设置该资源类型的副本数自动扩容到相关值 kubectl autoscale 资源类型 资源名称 --min=最小值 --max=最大值 # 设置该资源类型的副本数自动扩容到相关值。并根据CPU阈值扩容缩容。 kubectl autoscale 资源类型 资源名称 --max=最大值 --最小值 --cpu-percent=80# 修改证书资源。kubectl certificate# 标记节点不可调度kubectl cordon # 标记指定节点不可调度 kubectl cordon 节点名# 标记节点可调度kubectl uncordon # 标记指定节点可调度 kubectl uncordon 节点名 # 更新一个或多个节点上的nodes。kubectl taint # 执行命令到容器。kubectl exec # 执行指定命令到容器中。 kubectl exec 容器名 命令 # 分配伪终端已宿主级向容器添加命令。 kubectl exec 容器名 -- bash -c “命令” # 进入指定节点容器内。 kubectl exec 容器名 -it bash# 转发一个或多个本地端口到一个pod。kubectl port-forward # 将宿主级端口转发到容器中。 kubectl port-forward 容器名 宿主级端口:容器端口# 为kubernetes API Server启动服务代理kubectl proxy# 拷贝文件或目录到容器中。kubectl cp # 附加到一个进程到一个已经运行的容器。kubectl attach # 进入到一个运行的容器终端。 kubectl attach 容器名 # 通过文件名或标准输入对资源应用配置kubectl apply# 更新部署配置文件信息(配置文件格式.json .yaml)kubectl apply -f 配置文件 # 使用补丁修改、更新资源的字段。kubectl patch# 通过文件名或标准输入替换一个资源。kubectl replace # 重新创建配置文件内的资源 。配置文件可是(.yaml、.json) kubectl replace -f 配置文件 --force # 不同的API版本之间转换配置文件。YAML和JSON格式都接受。kubectl convert# 更新资源上的标签kubectl label# 在一个或多个资源上更新注释。kubectl annotate# 修改kubeconfig文件(用于访问API,比如配置认证信息)kubectl config查# 显示一个或多个资源kubectl get # 查看组件运行状态 kubectl get componentstatus # 查看节点加入信息 kubectl get node # 查看所有资源 kubectl get all # 查看pods状态 kubectl get pods # 查看pods及运行节点位置,查看更多信息 kubectl get pods -o wide # 查看pods下其他命名空间(kube-system等) kubectl get pods -n 命名空间 # 查看endpoints节点 kubectl get endpoints # 查看sservice暴露宿主级访问地址描述信息 kubectl get service # 根据标签查找资源描述信息。--output=wide查看更多信息。 kubectl get 资源类型 --selector="key=value" --output=wide # 查看资源所有标签 kubectl get 资源类型 --show-labels # 根据标签查看资源 kubectl get 资源类型 -l app=example # 查看指定命名空间的资源 kubectl get 资源类型 --namespace=kube-system # 查看命名空间 kubectl get ns# 文档参考资料,可查看yaml文件字段指令含义。kubectl explain # 获得资源的特定字段的文档 kubectl explain pods.spec.containers # 获得资源及其字段的文档 kubectl explain pods# 显示集群信息kubectl cluster-info # 显示详细集群信息 kubectl cluster-info dump# 显示资源(CPU/Memory/Storage)使用。需要Heapster运行。kubectl top# 显示特定资源或资源组的详细信。kubectl describe # 查看资源详细信息 kubectl describe 资源类型 资源名称 # 指定标签。详细信息。 kubectl describe 资源类型 -l name=标签名 # 查看node资源使用详情信息 kubectl describe nodes NodeIP# 在od或指定的资源中容器打印日志。如果od只有一个容器,容器名称是可选的。kubectl logs # 查看指定节点服务日志。 kubectl logs 容器名 # 查看指定容器日志。 kubectl logs pod 节点名 -c 容器名 # 查看指定容器日志。实时查看。 kubectl logs pod 容器名 -f # 通过标签查看容器日志 kubectl logs -l key=value其他# 检查认证授权kubectl auth# 用于实现kubectl工具自动补全kubectl completion# 执行实现自动补全动作source <(kubectl completion bash)# 打印受支持的API版本kubectl api-versions# 所有命令帮助。kubectl help# 运行一个命令行插件。kubectl plugin# 打印客户端和服务版本信息kubectl versionkubernetes官网https://kubernetes.io/kubernetes官方文档其他命令https://v1-8.docs.kubernetes.io/docs/reference/generated/kubectl/kubectl-commands - ubuntu 安装k8s 在vmware创建3台虚拟机,配置,4g/2vCPU/30G,ubuntu系统:Ubuntu 20.04.6。实验环境规划:两台机器:192.168.40.101是k8s控制节点192.168.40.103是k8s工作节点1、修改主机名控制节点:hostnamectl set-hostname umaster1 &&bashnodea节点:hostnamectl set-hostname unode1 &&bash2、更新apt源及安装基础软件包控制节点:root@umaster1:~# apt-get update && sudo apt-get install -y apt-transport-https ca-certificates curl software-properties-common gnupg2node节点:root@unode1:~# apt-get update && sudo apt-get install -y apt-transport-https ca-certificates curl software-properties-common gnupg2把下载的key添加到本地trusted数据库中控制节点:、root@umaster1:~# curl -fsSL https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu/gpg | sudo apt-key add -OKnode节点:curl -fsSL https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu/gpg | sudo apt-key add -OK3、配置同步时间 4、设置计划同步crontab root@umaster1:~# apt install cron #安装crontab服务Reading package lists... DoneBuilding dependency tree Reading state information... Donecron is already the newest version (3.0pl1-136ubuntu1).cron set to manually installed.The following packages were automatically installed and are no longer required: gir1.2-goa-1.0 libfwupdplugin1 libxmlb1Use 'apt autoremove' to remove them.0 upgraded, 0 newly installed, 0 to remove and 1 not upgraded.root@umaster1:~# service cron start #启动crontab进程root@umaster1:~# systemctl enable cron --now #设置随机启动Synchronizing state of cron.service with SysV service script with /lib/systemd/systemd-sysv-install.Executing: /lib/systemd/systemd-sysv-install enable cron root@umaster1:~# crontab -e 创建计划任务,no crontab for root - using an empty onecrontab: installing new crontabroot@umaster1:~# crontab -l #查看配置* */1 * * * /usb/sbin/ntpdate cn.pool.ntp.org #每一小时同步一次node节点可同步执行相同命令。4、关闭防火墙和交换分区1)查看防火墙,其中防火墙状态是active则表明防火墙是开启状态,而inactive则是关闭状态。:关闭防火墙执行命令:sudo ufw disable2)关闭交换分区:执行命令:sudo swapoff -a5、允许 iptables 检查桥接流量(所有节点)1.加载overlay和br_netfilter两个内核模块sudo modprobe overlay && sudo modprobe br_netfilter持久化加载上述两个模块,避免重启失效。2、修改内核参数,确保二层的网桥在转发包时也会被iptables的FORWARD规则所过滤.root@umaster1:~# cat <<EOF | sudo tee /etc/sysctl.d/k8s.confnet.bridge.bridge-nf-call-iptables = 1net.bridge.bridge-nf-call-ip6tables = 1net.ipv4.ip_foword = 1EOF6、设置稳定版仓库所有节点执行命令:root@umaster1:~# add-apt-repository "deb [arch=amd64] https://mirrors.ustc.edu.cn/docker-ce/linux/ubuntu/ $(lsb_release -cs) stable"7、安装Docker所有节点执行安装命令:root@umaster1:~# apt-get install docker-ce docker-ce-cli containerd.io -yroot@unode1:~# apt-get install docker-ce docker-ce-cli containerd.io -y8、配置Docker驱动1、root@umaster1:~#cat <<EOF | tee /etc/docker/daemon.json{"exec-opts": ["native.cgroupdriver=systemd"],"log-driver": "json-file","log-opts": {"max-size": "100m"},"storage-driver": "overlay2"}EOF然后执行以下操作:mkdir -pv /etc/systemd/system/docker.service.d #创建docker服务进程systemctl daemon-reload #加载配置文件systemctl restart docker #重启dockersystemctl enable docker --now #设置docer随机启动如下图生产节点node1也执行相同的操作,也可以同步进行。检查docker是否正常9、安装k8s控制节点操作命令:1):apt-get update && apt-get install -y apt-transport-https curl #升级并安装依赖包2):新增国内科大的软件源cat <<EOF >/etc/apt/sources.list.d/kubernetes.listdeb http://mirrors.ustc.edu.cn/kubernetes/apt kubernetes-xenial mainEOF#3)执行更新:apt-get update如果遇到以下报错,可以通过以下方法解决:执行命令: apt-key adv --recv-keys --keyserver keyserver.ubuntu.com +报错缺少的key如上图的报错解决:执行命令:root@umaster1:~# apt-key adv --recv-keys --keyserver keyserver.ubuntu.com B53DC80D13EDEF05执行安装k8s命令:安装kubelet,kubectl,kubeadm:1)、root@umaster1:~# apt-get install -y kubelet=1.23.1-00 kubeadm=1.23.1-00 kubectl=1.23.1-002)、关闭k8s自动更新:root@umaster1:~# apt-mark hold kubelet kubeadm kubectl 3)、初始化k8s执行以下命令:kubeadm init --apiserver-advertise-address 192.168.10.102 --image-repository registry.cn-hangzhou.aliyuncs.com/google_containers --pod-network-cidr=10.244.0.0/16 --ignore-preflight-errors=SystemVerification执行成功后有如下图示: 4)、创建用户操作root@umaster1:~# mkdir -p $HOME/.kuberoot@umaster1:~# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/configroot@umaster1:~# sudo chown $(id -u):$(id -g) $HOME/.kube/config5)、工作节点加入集群:kubeadm join 192.168.40.100:6443 --token u5jbsc.l3ya2fomnogcc68p \--discovery-token-ca-cert-hash sha256:407c9c1d46a2a865ff46120be41d49d56d9aea310b8a35a56724b60f17a6449f6)、